Pour assister les chirurgiens dans le cadre d’opérations sous endoscopie, des chercheurs du Laboratoire des sciences de l'ingénieur, de l'informatique et de l'imagerie (ICube) développent un algorithme dont l’apprentissage est basé sur l’utilisation des données fournies par le robot et les images de la caméra.

09/06/2021

La chirurgie endoscopique à l’aide d’instruments rigides s’est développée à partir des années 80 et la chirurgie robotisée depuis les années 2000. « Dans cette recherche, nous utilisons un endoscope flexible robotisé, utile par exemple pour des opérations dites « endoluminales » dans le tube digestif ou le colon », explique Benoit Rosa, chercheur CNRS à ICube qui travaille au côté de Luca Sestini, doctorant, à ajouter un certain niveau d’autonomie à ces instruments par une assistance aux gestes à l’aide d’un algorithme.

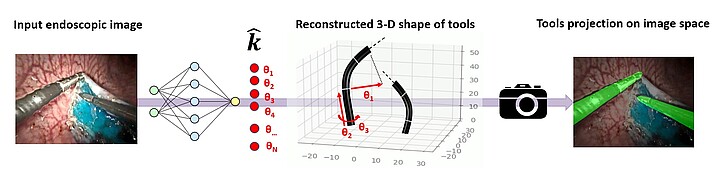

Objectif : « Faire de la chirurgie de manière plus intuitive et plus sûre. » Le tout, dans le cadre d’un projet européen International treaning network (ITN) en collaboration avec six autres universités européennes, dont l’université polytechnique de Milan. Dans un article paru dans IEEE Robotics and Automation Letters, le chercheur et son équipe sont parvenus à réaliser avec une algorithme une estimation de la pose des instruments robotisés par rapport à la caméra. L'originalité de l'approche tient dans l'exploitation conjointe d'un modèle donnant la forme du robot à partir des données moteur, et des images fournies par la caméra endoscopique.

Généraliser les apprentissages

« Pour entrainer l’algorithme, il faut estimer la position 3D des instruments dans le corps ce qui nécessite beaucoup de données. Dans le cadre d’une approche supervisée, il faudrait que le chirurgien annote un très grand nombre d’images pour que l’algorithme puisse apprendre », détaille le chercheur qui souligne que l’utilisation des seules données moteur du robot fournissent des résultats moins performants qu’un algorithme supervisé. Raison pour laquelle il a opté pour le couplage des données moteur avec les images de la caméra.

Prochaine étape : faire en sorte de ne plus avoir besoin des informations moteur du robot. Ce qui permettrait de généraliser les apprentissages sur d’autres types de robots, « comme ceux pour lesquels nous n’avons pas accès aux informations moteurs. »

A plus long terme, les chercheurs souhaiteraient combiner cette approche à des modèles prenant en compte d’autres aspects pour connaitre par exemple la force exercée sur un tissu du corps. « Le chirurgien ne peut aujourd’hui compter que sur un retour visuel. En améliorant son retour sensitif grâce aux efforts exercés sur les tissus, nous pourrions ainsi contribuer à rendre les chirurgies plus sûres et efficaces. »

Marion Riegert